운영 효율성과 통찰을 동시에: Prometheus와 WhaTap의 하이브리드 관측 전략

이 글은 와탭이 외부 필진과 협력하여 제작한 콘텐츠로, 현업에서 활동하는 전문가의 경험과 인사이트를 독자 여러분께 전달하고자 합니다.

이 글은 대규모 환경에서 Prometheus와 Grafana를 효과적으로 운영하기 위한 실용적인 로드맵을 제공합니다. 먼저 널리 사용되는 오픈소스 스택과 상용 SaaS(Software as a Service) 플랫폼을 비교 분석하고, 나아가 오픈소스와 상용 서비스인 와탭(WhaTap)을 함께 사용하여 시너지를 내는 '하이브리드 관측성 전략'을 구체적으로 다룰 것입니다.

확장성을 고려한 아키텍처 설계부터 성능 최적화, 그리고 두 세계의 장점을 모두 활용하는 현실적인 가이드를 통해, 독자들이 장애를 조기에 탐지하고 깊이 있는 인사이트를 얻는 방법을 습득하는 것을 목표로 합니다.

1. 최신 관측성(Observability)의 도전 과제

1.1. 클라우드 네이티브 시스템의 복잡성 증가

초기 단계의 많은 조직은 단일 Prometheus 인스턴스로 모놀리식 애플리케이션을 모니터링하는 것으로 시작합니다. 이 방식은 단순하고 효과적이며, 시스템의 상태를 파악하는 데 충분합니다. 하지만 비즈니스가 성장하고 기술 스택이 진화함에 따라 이러한 단순한 구조는 한계에 부딪힙니다.

마이크로서비스 아키텍처(MSA), 쿠버네티스 클러스터, 서버리스 함수, 멀티 클라우드 환경이 도입되면서 모니터링해야 할 대상과 메트릭의 양은 기하급수적으로 폭발합니다. 이제 문제는 "서버가 다운되었는가?"가 아니라 "서로 의존하는 수십 개의 서비스 중 왜 사용자 경험이 저하되고 있는가?"와 같이 복잡하고 다차원적으로 변합니다. 이러한 분산 환경에서는 개별 서비스의 장애가 전체 시스템으로 전파될 수 있으며, 여러 서비스에 걸친 통합 테스트와 디버깅의 복잡성은 크게 증가합니다.

이러한 환경의 폭발적인 복잡성은 단순히 더 많은 메트릭을 수집하는 것으로 해결되지 않습니다. 근본적으로 디버깅의 선형적인 경로가 사라졌다는 것이 핵심 문제입니다. 이는 전통적인 모니터링(알려진 불확실성을 추적하는 것)의 한계를 드러내며, 시스템 내부 상태를 외부 출력을 통해 추론하는 관측성(알려지지 않은 불확실성을 탐색하는 것)으로의 전환을 요구합니다.

진정한 관측성은 메트릭, 트레이스, 로그라는 세 가지 핵심 데이터를 유기적으로 연결하여 시스템의 동작을 종합적으로 이해하는 능력에서 비롯됩니다. 따라서 메트릭 중심의 솔루션만으로는 복잡한 장애의 근본 원인을 파악하기에 불충분한 경우가 많습니다.

1.2. 전략적 갈림길: 자체 구축 OSS 대 SaaS 기반 플랫폼

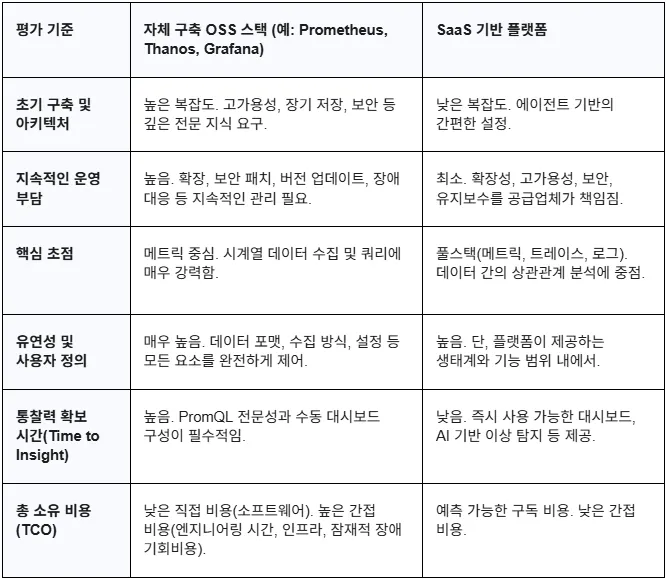

대규모 모니터링 환경을 구축하려는 조직은 근본적인 전략적 선택에 직면합니다. 한쪽에는 모든 것을 직접 제어하는 자체 구축 오픈소스 스택(Prometheus, Grafana, Thanos 등)이 있고, 다른 한쪽에는 운영 부담을 최소화하는 SaaS 기반 플랫폼(예: WhaTap, Datadog, New Relic)이 있습니다.

이 두 접근 방식의 차이를 이해하는 것은 단순히 기능 목록을 비교하는 것을 넘어, 조직의 가장 귀중한 자원인 엔지니어링 시간을 어디에 집중할 것인지 결정하는 과정입니다. 자체 구축 OSS 스택은 초기 소프트웨어 비용이 없지만, 아키텍처 설계, 고가용성 구성, 장기 저장소 연동, 보안 패치, 성능 튜닝 등 막대한 운영 오버헤드를 수반합니다. 반면 SaaS 플랫폼은 구독 기반 비용 모델을 가지지만, 이러한 운영 부담을 공급업체에 위임하고 즉시 사용 가능한 고급 기능(AIOps, 자동화된 이상 탐지 등)을 활용할 수 있게 해줍니다.

이 선택은 기술적인 문제를 넘어 조직의 전략과 직결됩니다. 총 소유 비용(TCO)을 평가할 때, 소프트웨어 라이선스나 서버 비용뿐만 아니라, 모니터링 스택 유지보수에 투입되는 엔지니어의 기회비용까지 고려해야 합니다. 핵심 제품 기능 개발이 아닌 인프라 유지보수에 고급 엔지니어의 시간을 사용하는 것이 과연 최선인지에 대한 전략적 판단이 필요합니다. 아래 표는 두 접근 방식의 주요 특징을 보다 깊이 있게 비교한 것입니다.

1.3. 하이브리드 접근법: 오픈소스와 상용 서비스의 시너지

이 글은 단순히 오픈소스와 상용 서비스를 비교 분석하는 것을 넘어, 두 세계의 장점을 모두 활용하여 효과적인 운영 전략을 구축하는 하이브리드 접근법을 제안합니다. 이는 단순히 타협안이 아니라, 기술적 유연성과 비즈니스 속도를 모두 최적화하는 의도적인 아키텍처 패턴입니다.

이 전략의 핵심 철학은 다음과 같습니다.

- Prometheus의 강점 활용: 방대한 Exporter 생태계를 통해 비즈니스에 특화된 커스텀 메트릭을 수집하는 등 Prometheus가 가장 잘하는 영역에 집중합니다. 이를 통해 시스템의 모든 구석에서 유연하고 강력한 메트릭 수집 능력을 확보합니다.

- SaaS 플랫폼의 고급 기능 활용: 데이터의 장기 보관, 확장성, 고가용성 유지보수와 같은 차별성 없는 힘든 작업을 플랫폼에 위임합니다. 더 중요한 것은, SaaS 플랫폼이 제공하는 분산 추적, 로그 상관 분석과 같은 통합 분석 기능을 활용하여 "What"이 일어났는지(메트릭)를 넘어 "Why" 그것이 일어났는지(코드 수준의 문제)를 파악하는 것입니다.

이 하이브리드 접근법을 통해 조직은 장애를 조기에 탐지하고, 일원화된 대시보드에서 깊이 있는 인사이트를 얻는 방법을 습득하게 될 것입니다. 궁극적으로 이는 장애 대응 시간을 획기적으로 단축하고, 엔지니어링 팀이 문제 해결이 아닌 혁신에 집중할 수 있는 환경을 조성하는 가장 현실적인 방안입니다.

2. 오픈소스 기반 아키텍처 구축

2.1. 안정적인 Prometheus 스택 구축: 고가용성과 페더레이션

단일 Prometheus 인스턴스는 고가용성 부재와 수직적 확장의 한계라는 명확한 문제점을 가집니다. 이를 극복하기 위한 첫 단계는 고가용성(HA)과 페더레이션(Federation) 구조를 도입하는 것입니다.

- 고가용성(HA) 패턴: 동일한 설정을 가진 두 개 이상의 Prometheus 인스턴스가 동일한 대상을 동시에 수집(Scrape)하는 구조입니다. 하나의 인스턴스에 장애가 발생해도 다른 인스턴스가 모니터링을 지속할 수 있습니다. 이때, 중복된 알림은 Alertmanager의 클러스터링 기능을 통해 그룹화하여 처리합니다.

- 페더레이션(Federation) 패턴: 여러 데이터 센터나 클러스터에 분산된 Prometheus 인스턴스로부터 집계된 데이터를 상위의 중앙 Prometheus가 수집하는 계층적 구조입니다. 이는 전역적인 상황을 요약해서 보는 데 유용하지만, 상세한 메트릭을 모두 볼 수 있는 전역 쿼리 뷰(Global Query View)를 제공하지는 못하며, 상위 Prometheus 자체가 병목이 될 수 있다는 단점이 있습니다.

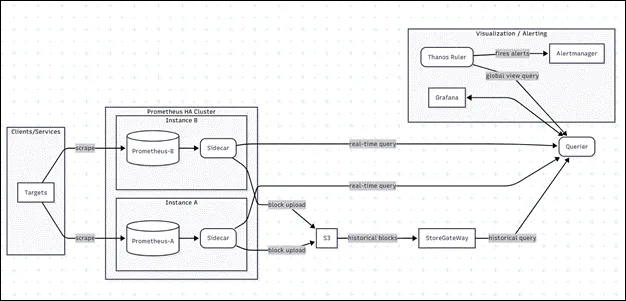

2.2. 대규모 확장을 위한 해결책: Thanos를 이용한 장기 저장 및 글로벌 쿼리

HA와 Federation만으로는 대규모 환경의 '전역 쿼리 뷰'와 '장기 데이터 보관'이라는 핵심 과제를 해결하기 어렵습니다. 이를 위해 등장한 솔루션이 바로 Thanos입니다. Thanos는 각 Prometheus 인스턴스에 Sidecar 컴포넌트를 함께 배포하여, 생성된 TSDB 블록을 AWS S3와 같은 저렴한 오브젝트 스토리지에 업로드합니다.

사용자의 쿼리는 Querier 컴포넌트가 받아서 처리합니다. 실시간 데이터는 각 Prometheus 인스턴스에서 직접 가져오고, 과거 데이터는 오브젝트 스토리지에 접근하는 Store Gateway를 통해 가져와 통합된 결과를 제공합니다. 이 아키텍처의 가장 큰 장점은 기존 Prometheus 환경을 거의 수정하지 않고도 수평적으로 확장할 수 있다는 점입니다.

하지만, Thanos가 저장 및 쿼리 문제를 기술적으로 해결하더라도, 이는 또 다른 운영 복잡성을 야기합니다. 이제 팀은 Sidecar, Querier, Store Gateway, Compactor 등 여러 분산 컴포넌트를 관리하고, 오브젝트 스토리지의 생명주기 정책을 설정하며, 컴포넌트 간 네트워크 지연 문제를 해결해야 합니다. 이러한 복잡성은 하이브리드 전략에서 왜 운영 부담을 SaaS 플랫폼으로 이전하는 것이 매력적인 선택지인지를 명확히 보여주는 지점입니다.

2.3. 미래를 위한 계측: OpenTelemetry 통합

관측성 전략을 수립할 때 현재의 요구사항뿐만 아니라 미래의 확장성까지 고려하는 것이 중요합니다. 여기서 OpenTelemetry(OTel)는 핵심적인 역할을 수행합니다. OTel은 CNCF(Cloud Native Computing Foundation)가 주도하는 프로젝트로, 텔레메트리 데이터(메트릭, 트레이스, 로그)를 생성하고 수집하기 위한 단일화된, 벤더 중립적인 표준입니다. 핵심 가치는 애플리케이션 계측(instrumentation) 코드를 특정 모니터링 백엔드로부터 분리하는 데 있습니다.

- Prometheus와 OTel의 연동 방식: OTel으로 계측된 애플리케이션은 수집된 텔레메트리 데이터를 다양한 포맷으로 내보낼 수 있습니다. OTel Collector는 Prometheus와 OTel 생태계를 잇는 강력한 다리 역할을 합니다. Collector는 Prometheus 엔드포인트를 스크레이핑하거나 OTLP(OpenTelemetry Protocol) 데이터를 수신한 후, 이를 Prometheus 서버를 포함한 여러 백엔드로 전달할 수 있습니다.

- OTLP의 이점과 최신 통합: 더 나아가, 최신 Prometheus는 --web.enable-otlp-receiver 플래그를 통해 OTel의 네이티브 프로토콜인 OTLP를 직접 수신할 수 있습니다. 이는 중간에 Collector 없이도 OTel 계측 애플리케이션의 메트릭을 Prometheus가 직접 수집할 수 있게 하여 파이프라인을 단순화합니다. 특히 '리소스 속성 승격(resource attribute promotion)' 기능은 OTel의 풍부하고 표준화된 속성(예: service.name, service.namespace)을 Prometheus 레이블로 자동 변환하여, 기존의 job, instance 레이블 사용 시 발생했던 여러 불편함을 해결합니다.

OpenTelemetry를 채택하는 것은 하이브리드 관측성 전략을 미래에도 유효하게 만드는 궁극적인 방법입니다. 애플리케이션을 OTel 표준에 맞춰 한 번만 계측하면, 조직은 최대의 유연성을 확보하게 됩니다. 동일한 텔레메트리 데이터를 자체 구축한 Prometheus 스택과 SaaS 플랫폼으로 동시에 전송할 수 있습니다. 향후 SaaS 벤더를 교체하거나 Prometheus 스택의 일부를 다른 기술로 대체하더라도, 애플리케이션 코드를 수정할 필요가 없습니다. 이는 특정 기술이나 벤더에 대한 종속성을 극적으로 낮추고 장기적인 기술 부채를 줄여주는 강력한 전략적 이점입니다.

3. 하이브리드 관측성 전략 실행

3.1. 통합 패턴: Prometheus와 SaaS 플랫폼 연결

Prometheus 스택과 SaaS 플랫폼을 연결하는 방법은 여러 가지가 있으며, 각 패턴은 아키텍처에 중요한 영향을 미칩니다. 조직의 요구사항에 맞는 최적의 패턴을 선택하기 위해서는 각 방식의 장단점을 명확히 이해해야 합니다.

- Prometheus remote_write: Prometheus가 수집한 메트릭을 실시간으로 SaaS 플랫폼이 제공하는 호환 HTTP 엔드포인트로 푸시(Push)하는 방식입니다. New Relic과 같은 플랫폼에서 널리 사용되는 패턴입니다.

- 에이전트 기반 스크레이핑: SaaS 벤더가 제공하는 경량 에이전트(예: Datadog Agent)를 Prometheus와 동일한 환경에 배포하여, 에이전트가 직접 Prometheus 엔드포인트를 스크레이핑(Pull)하는 방식입니다.

- OpenTelemetry Collector 허브: OTel Collector가 Prometheus 엔드포인트로부터 데이터를 수집한 후, 다양한 Exporter를 사용하여 로컬 Prometheus 서버와 SaaS 플랫폼 등 여러 백엔드로 데이터를 동시에 전송하는 방식입니다. 가장 유연하고 벤더 중립적인 접근법입니다.

이러한 선택은 단순한 기술 구현을 넘어 아키텍처 철학과 직결됩니다. remote_write는 Prometheus 서버와 백엔드를 강하게 결합시키는 반면, 에이전트 기반 스크레이핑은 둘을 분리하지만 추가적인 에이전트 관리 부담을 발생시킵니다. OTel Collector는 최고의 유연성을 제공하지만, 관리해야 할 구성요소가 하나 더 늘어납니다.

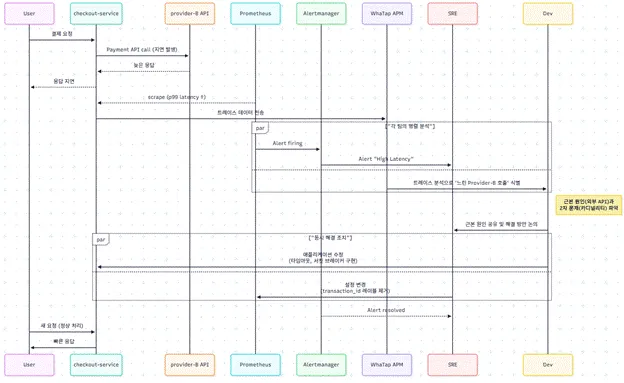

3.2. 실용적 사용 사례: Prometheus 알림("What")에서 근본 원인("Why")까지

하이브리드 아키텍처의 진정한 가치는 실제 장애 상황에서 드러납니다. Prometheus가 보낸 신호("무엇"에 대한 문제)를 통합 관측성 플랫폼의 심층 분석 능력("왜"에 대한 해답)과 결합하여 문제 해결 시간을 획기적으로 단축하는 과정을 살펴보겠습니다. 이러한 플랫폼들은 APM(Application Performance Monitoring) 기능을 포함하여 풀스택 가시성을 제공합니다.

시나리오: Prometheus의 Alertmanager가 특정 서비스에서 'p99 지연 시간 임계치 초과' 알림을 발생시켰습니다. 이것이 바로 "What"에 해당하는 신호입니다. SRE는 즉시 알림을 인지하지만, 메트릭만으로는 "왜" 지연이 발생했는지 알 수 없습니다.

하이브리드 워크플로우:

- 신호 감지: Prometheus가 high latency 알림을 발생시키고 SRE에게 통지합니다.

- 컨텍스트 전환: SRE는 이 알림을 받고 문제의 근본 원인을 찾기 위해 통합 관측성 플랫폼(이 사례에서는 WhaTap)으로 이동합니다.

- 심층 분석: 플랫폼에서 알림이 발생한 시간대의 해당 서비스 트랜잭션 데이터를 필터링합니다. 분산 추적(Distributed Tracing) 뷰를 통해 SRE는 개별 요청이 시스템의 어떤 경로를 통해 처리되었는지 시각적으로 확인할 수 있습니다.

- 원인 규명: 트레이스 분석 결과, 특정 외부 의존성 API(provider-B API) 호출에서 대부분의 시간이 소요되고 있음을 즉시 발견합니다. 이것이 바로 "Why"에 대한 명확하고 실행 가능한 해답입니다. Prometheus 메트릭만으로는 결코 얻을 수 없었던 구체적인 원인입니다.

이 하이브리드 워크플로우는 장애 대응 프로세스를 근본적으로 변화시킵니다. 과거에는 로그 파일을 뒤지고, 서버에 접속하고, 추측에 의존하던 느리고 수동적인 조사 과정이, 이제는 데이터를 기반으로 한 빠르고 체계적인 진단 과정으로 전환됩니다. 이는 평균 해결 시간(MTTR)의 직접적이고 측정 가능한 단축으로 이어지며, "진단 시간을 몇 시간에서 몇 분으로 줄였다"와 같이 정량화할 수 있는 비즈니스 가치를 창출합니다.

3.3. 통합 시각화: Grafana를 통한 단일 창(Single Pane of Glass) 구현

여러 시스템에 분산된 데이터를 통합하여 보여주는 '단일 창'은 모든 모니터링 시스템의 오랜 목표입니다. Grafana는 이러한 목표를 달성하기 위한 강력한 도구를 제공합니다.

- 다중 데이터 소스 지원: Grafana는 Prometheus/Thanos 인스턴스와 SaaS 플랫폼(Grafana 데이터 소스 플러그인을 제공하는 경우, 예: New Relic)을 각각 별개의 데이터 소스로 손쉽게 추가할 수 있습니다.

- 혼합 데이터 소스(Mixed Data Sources): 단일 Grafana 패널 안에서 여러 데이터 소스의 쿼리 결과를 함께 시각화할 수 있습니다. 예를 들어, 한 그래프에는 Prometheus에서 가져온 p99 latency 메트릭을, 바로 아래 패널에는 SaaS 플랫폼에서 가져온 error rate를 표시하여 상관관계를 한눈에 파악할 수 있습니다.

- 데이터 링크(Data Links): Grafana의 데이터 링크 기능은 강력한 워크플로우를 구축하게 해줍니다. Prometheus 알림을 보여주는 패널에 동적 링크를 설정하여, 클릭 시 서비스 이름이나 타임스탬프 같은 컨텍스트 정보를 가지고 SaaS 플랫폼의 해당 트레이스 분석 화면으로 바로 이동하게 만들 수 있습니다.

이러한 기능들을 조합하면 단순히 그래프를 모아놓은 대시보드를 넘어, 상호작용이 가능한 '탐정 워크플로우'를 구축할 수 있습니다. 엔지니어는 고수준의 증상(Prometheus 메트릭)에서 시작하여 저수준의 원인(SaaS 플랫폼의 트레이스)까지 드릴다운하는 과정을 주 모니터링 인터페이스를 벗어나지 않고 수행할 수 있어, 장애 상황에서의 워크플로우 효율성을 극적으로 향상시킵니다.

4. 운영 효율성 및 최적화

4.1. Prometheus 성능 마스터하기: 카디널리티와 스크레이프 설정

대규모 Prometheus 환경에서 성능 저하를 일으키는 가장 주된 원인은 '높은 카디널리티(High Cardinality)'와 부적절한 스크레이프 설정입니다.

- 높은 카디널리티 관리: 카디널리티는 메트릭 이름과 레이블 값의 조합으로 생성되는 고유한 시계열(Time Series)의 수를 의미합니다. 사용자 ID, 세션 ID, 트랜잭션 ID와 같이 무한한 값을 가질 수 있는 정보는 레이블로 사용하지 않는 것이 원칙입니다.

topk(10, count by (__name__)({__name__=~".+"})) 와 같은 PromQL 쿼리를 통해 문제의 원인이 되는 메트릭을 찾고, metric_relabel_configs를 사용하여 수집 단계에서 불필요한 레이블을 제거할 수 있습니다. 카디널리티 관리는 단순히 기술적인 튜닝을 넘어, 개발 단계에서부터 올바른 메트릭 계측 가이드를 제공하고 '메트릭 리뷰' 프로세스를 도입하는 등 조직적인 거버넌스의 문제로 접근해야 합니다. - 스크레이프 설정 튜닝: scrape_interval(수집 주기)은 Prometheus의 부하와 직접적인 관련이 있습니다. 모든 메트릭을 동일한 주기로 수집하기보다는, 서비스의 중요도에 따라 15초, 60초 등으로 차등을 두는 것이 현명합니다. 또한, Thanos와 같은 장기 보관 솔루션을 사용한다면, 로컬 디스크 보관 주기(--storage.tsdb.retention.time)는 24~48시간 정도로 짧게 유지하여 디스크 사용량을 최소화하는 것이 효율적입니다.

4.2. 장기 데이터 관리 및 TCO 고려사항

데이터 보관 전략은 총 소유 비용(TCO)에 직접적인 영향을 미칩니다. 수년간의 고해상도 메트릭을 자체 호스팅 솔루션에 저장하는 것은 비용과 복잡성 측면에서 부담이 될 수 있습니다. 하이브리드 모델은 계층적 저장 전략을 가능하게 합니다.

- 계층적 저장: 최근 데이터(Hot Data)는 빠른 운영 쿼리를 위해 Prometheus 로컬 디스크에 짧게 보관합니다. 반면, 과거 데이터(Cold Data)는 역사적 분석 및 규정 준수를 위해 비용 효율적인 스토리지 계층(Thanos를 통한 오브젝트 스토리지 또는 SaaS 플랫폼의 관리형 스토리지)으로 오프로드합니다. 이는 관리형 Prometheus 서비스의 비용 구조(수집, 저장, 쿼리)를 고려할 때 더욱 정교한 비용 관리 접근법입니다.

4.3. 코드형 인프라(IaC)를 통한 배포 자동화

대규모 환경에서는 수십 대의 모니터링 서버를 일관되게 설정해야 하므로, Ansible, Terraform, Helm과 같은 자동화 도구를 활용하여 Prometheus, Grafana, Alertmanager 배포를 표준화하는 것이 필수적입니다. 코드형 인프라(Infrastructure as Code, IaC) 접근 방식을 통해 신규 인스턴스 추가나 설정 변경을 코드로 관리하여 실수를 줄이고 신속하게 적용할 수 있습니다.

5. 결론: 지속 가능한 관측성 프랙티스 구축

5.1. 하이브리드 전략의 장점 종합

대규모 모니터링 환경을 성공적으로 운영하려면 오픈소스 솔루션의 유연성과 SaaS 서비스의 편의성을 조합하는 하이브리드 접근 방식이 가장 효과적입니다.

- 유연성을 위한 Prometheus: 클라우드 네이티브 환경에서 커스텀 메트릭을 수집하기 위한 사실상의 표준으로, 타의 추종을 불허하는 유연성을 제공합니다.

- 속도를 위한 SaaS: 풀스택 관측성 플랫폼은 MTTR을 줄이고 엔지니어링 리소스를 확보하는 데 필요한 핵심 컨텍스트(트레이스, 로그)와 고급 분석 기능(AIOps, 이상 탐지)을 제공합니다.

- 미래를 위한 OpenTelemetry: 계측을 위해 OTel 표준을 채택하는 것은 장기적인 아키텍처 민첩성을 보장하고 벤더 종속을 방지합니다.

궁극적인 목표는 단순히 더 많은 데이터를 보는 것이 아니라, 팀이 그 데이터에 기반하여 더 빠르고 지능적으로 행동할 수 있도록 역량을 부여하는 것입니다. 성공적인 하이브리드 전략은 선순환 구조를 만듭니다. Prometheus가 광범위한 신호를 제공하고, SaaS 플랫폼이 심층적인 진단 능력을 제공하며, 여기서 얻은 통찰력은 더 안정적인 시스템을 구축하는 데 다시 피드백됩니다. 이는 조직을 수동적인 '장애 대응' 문화에서 능동적인 '안정성을 위한 엔지니어링' 문화로 발전시킵니다.

5.2. 엔지니어링 리더를 위한 핵심 제언

- OSS와 SaaS 사이에서 하나만을 선택하기보다, 두 솔루션의 강점을 모두 활용하는 하이브리드 전략을 고려하는 것이 현명합니다.

- 관측성은 더 이상 부가 기능이 아닌 핵심 제품의 일부로 다루어져야 합니다. 이를 위해 OpenTelemetry와 같은 명확한 계측 표준에 투자하여 장기적인 기술 유연성을 확보하는 것이 중요합니다.

- 측정의 초점은 장애 평균 해결 시간(MTTR) 감소와 핵심 가치에 집중할 수 있는 엔지니어링 시간 확보에 맞춰져야 합니다. 잘 설계된 관측성 스택은 비즈니스 속도 향상에 직접적으로 기여할 수 있습니다.

- 궁극적으로 우리가 나아가야 할 방향은 장애 발생 후 대응하는 '수동적 모니터링'을 넘어, 시스템의 동작을 깊이 이해하여 장애를 사전에 예방하는 '능동적 관측성'으로 진화하는 것입니다. 이 글에서 제안하는 하이브리드 전략은 이러한 진화를 가능하게 하는 현실적이고 강력한 기반이 되어줄 것입니다.

.svg)

![[인터뷰] GPU 담당자가 전하는 GPU 운영의 현실과 미래](https://cdn.prod.website-files.com/683542e0144e8b6bf7a76d7b/6980491a08e3c000e3284a30_%E1%84%8B%E1%85%AA%E1%84%90%E1%85%A2%E1%86%B8%E1%84%85%E1%85%A2%E1%86%B8%E1%84%89%E1%85%B3_260127-01_%E1%84%82%E1%85%A1%E1%86%AF%E1%84%8D%E1%85%A1%E1%84%89%E1%85%AE%E1%84%8C%E1%85%A5%E1%86%BC%20(1).webp)